你好,我frp内网穿透,tcp都能搞好,就是http的搞不好。因为想要远程管理i...

HQY一个和谐有爱的空间醉里寻她,陌上人,何处是黄昏,留恋覆水人家,一场清秋…… 本站的内容,主要用来记录学习过程,不存在任何争议,部分原创,部分收录来源于互联网,如果有侵权,请留言联系我进行删除。...

还有 7 人发表了评论 加入15235人围观HQY一个和谐有爱的空间醉里寻她,陌上人,何处是黄昏,留恋覆水人家,一场清秋…… 本站的内容,主要用来记录学习过程,不存在任何争议,部分原创,部分收录来源于互联网,如果有侵权,请留言联系我进行删除。...

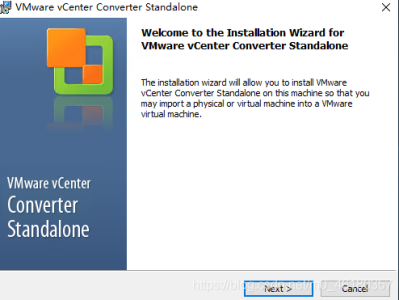

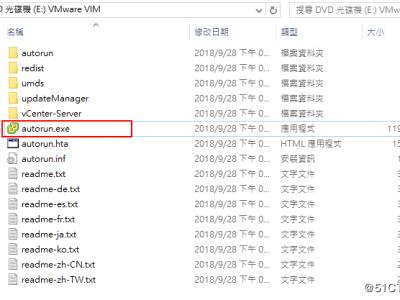

还有 7 人发表了评论 加入15235人围观一、 VMware Convert

工具安装

1、安装介质名称 VMware-converter-en-5.5.0-1362012.exe

2、工具安装

双击安装介质

Local installation 适合于安装于服务器端的

Client-server installation 适合于安装于客户端的模式

Install

二、 windows 系统迁移

温故:

在《VMware vCenter Converter 安装(二)----英文版》中我在网上给大家找到了英文版的P2V过程,图片也并不是特别清楚,所以今天又特意找了一篇中文版的转换流程的文章,大家可以对比着这两篇文章去看:

链接如下:VMware Converter 转换过程(一)----英文版

https://blog.csdn.net/Gao068465/article/details/116836271

知新:

一、环境准备

准备VMware-converter-en-6.2.0-8466193软件安装程序

准备一台windows服务器和一台ESXI服务器或vCenter地址

二、安装

双击打开VMware vCenter Converter Standalone文件

https://customerconnect.vmware.com/downloads/#all_products

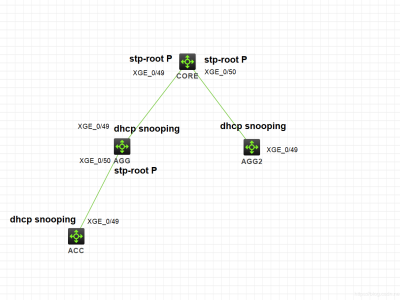

我们知道在企业网络中当网络设备众多的时候,我们通常会选择用LLDB的方式查看邻居关系,从而很好的知道相应的邻居关系。

[CORE]display lldp neighbor-information list //查看所有的邻居

Chassis ID : * -- -- Nearest nontpmr bridge neighbor

# -- -- Nearest customer bridge neighbor

设备收到此消息 Instance 0's port Bridge-Aggregation1 received no BPDU within the rcvdInfoWhile interval.

企业核心交换机上级联了多个交换机时,我们想查看哪些端口接了哪些交换机,可以使用快捷命令,display lldp neighbor brief

我们通常需要对众多网络设备进行统一命名,只有统一命名以后,我们使用这条命令才有意义。

华为交换机:

[CORE]lldp enable //华为交换机都要手动开启这个服务

Info: Global LLDP is already enabled.

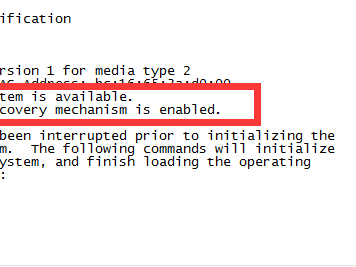

交换机重新上电,上电过程中,按住交换机正面"mode"按钮,直到sys灯变为绿色且快速闪动,或者当CRT里出现The password-recovery mechanism is enabled.提示信息时候松开mode,进入到交换机的底层模式switch

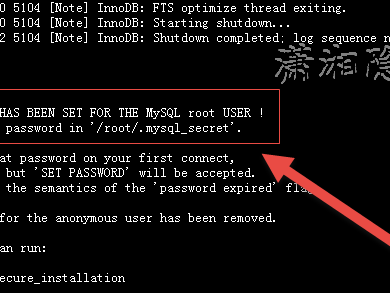

刚刚安装好了mysql数据库,root用户登录没有问题,但是在创建了新的数据库后却无法登录,报“ERROR 1045 (28000): Access denied for user”这样的错误,下面对这个错误进行重演,首先以root用户登录: