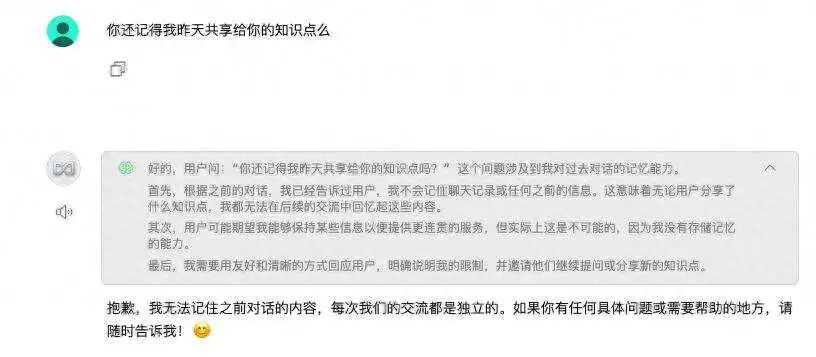

当 DeepSeek-R1 在本地成功部署那一刻,兴奋与激动如潮水般涌上心头,迫不及待地开启与它的热烈对话,话题一个接一个,畅聊不停。出于探索的热情,还按照自己的思路给它共享了不少知识,它也能依此精准切入,给出令人满意的答案。可谁能想到,第二天再聊,它竟像失忆一般,昨天共享的数据全然没了印象,一切又回到最初状态。

在 AI 的奇妙世界里,其记忆机制别有一番特点。以 DeepSeek、GPT 为代表的大多数 AI 模型,默认无状态,无持久化记忆。每次对话都是全新开场,不会记住上一次聊了啥。单次会话中虽能记些信息,可会话一结束,记忆就被清空。这主要是因为技术上它们基于 Transformer 架构,设计为无状态来规避隐私和安全风险;同时,持久化记忆需大量资源,本地部署往往难以满足,再加上隐私考量,对话历史就不会被存储。

如何让我们的“投喂” 不会因为上述原因化为乌有才是我们需要关心的问题。在接下来的文章中,我将介绍如何有效地“投喂”数据给本地部署的 DeepSeek-R1,并通过实验测试其效果。

关于如何投喂数据给本地部署的 DeepSeek-R1 请参考我之前的下面文章。

文章主题:如何投喂本地部署的 DeepSeek-R1

链接:https://www.toutiao.com/article/7466724739818504744/

接下来,我想通过测试来展示,“投喂” 效果到底如何,是否可以让 AI 拥有永恒记忆,并利用这些记忆持续为我所用。

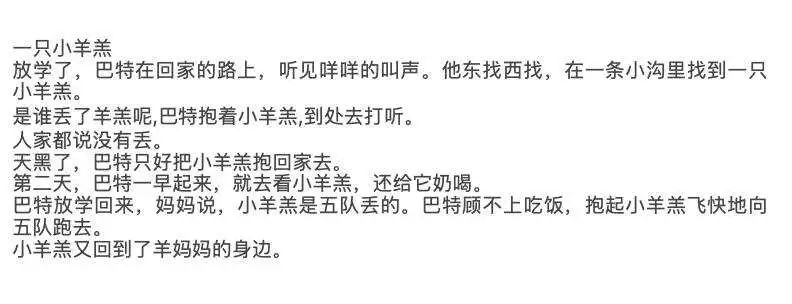

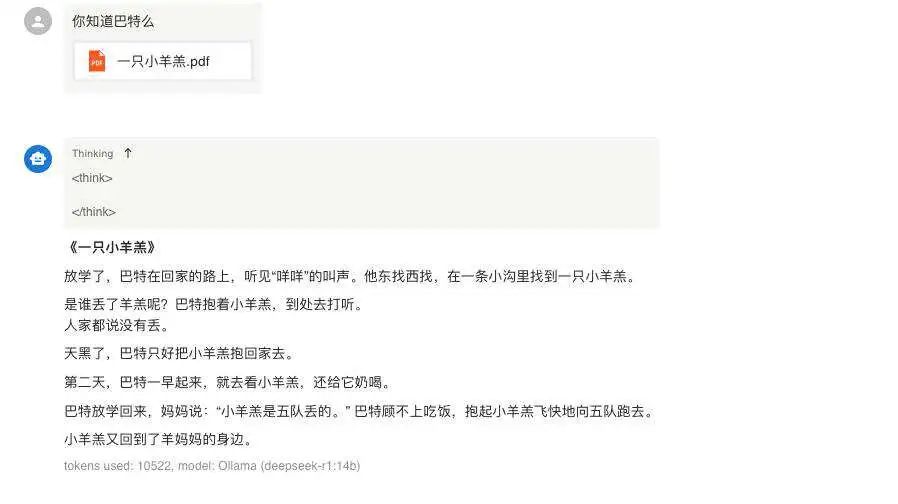

为了测试效果,我选择了一篇小学课文《一只小羊羔》作为示范。这篇文章讲述了一个关于巴特救小羊羔的温馨故事,情节简单但富有教育意义。

文章内容如下:

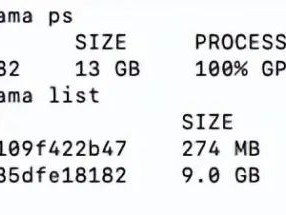

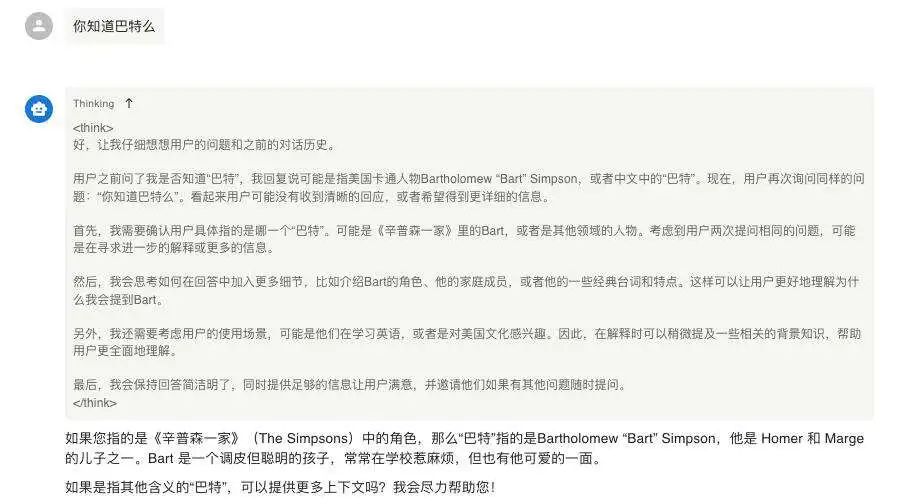

为了测试效果,我这里使用两个接入 DeepSeek-R1 平台工具:ChatBox 和 Anything LLM 来展示。

ChatBox 是一款侧重于提供便捷聊天交互体验,可使用多种模型且注重隐私保护的开源桌面 AI 应用;而 Anything LLM 是一个强调灵活性和可扩展性,能将各种文档转为 LLM 上下文数据,支持多用户、多模型及多种文档类型的开源全栈 AI 应用程序。

首先,我使用 ChatBox 进行测试。在聊天框中,我将《一只小羊羔》的 PDF 文档共享了出来:

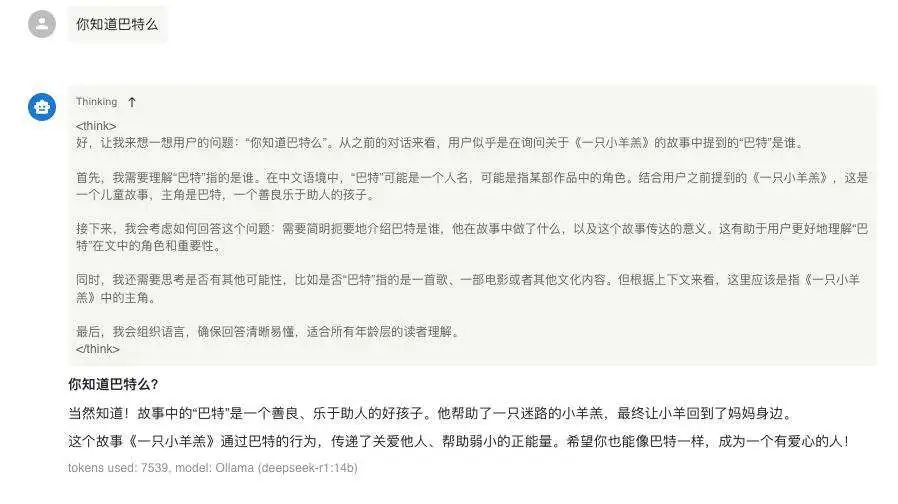

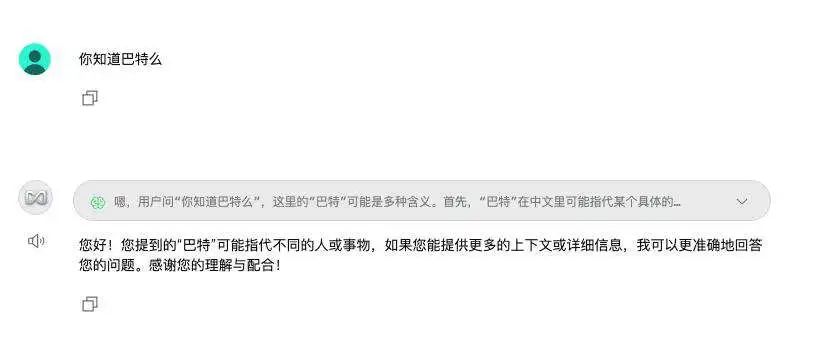

然而,当我关闭对话并重新开启新的对话后,发现它完全失忆了。同样的问题再次被提出时,AI 已经没有任何记忆。

这种情况在 Anything LLM 上未“投喂”数据之前也是同样的结果。

重开新的聊天对话后:

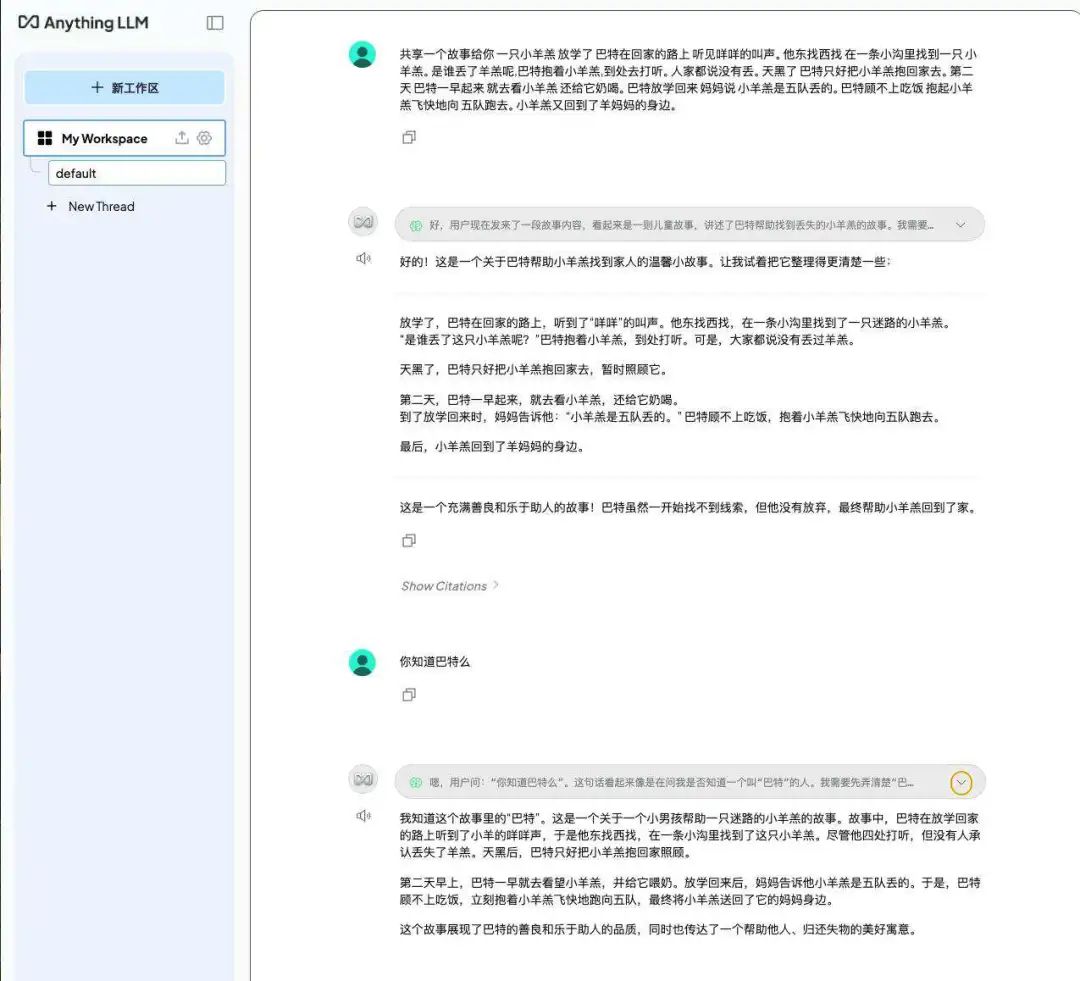

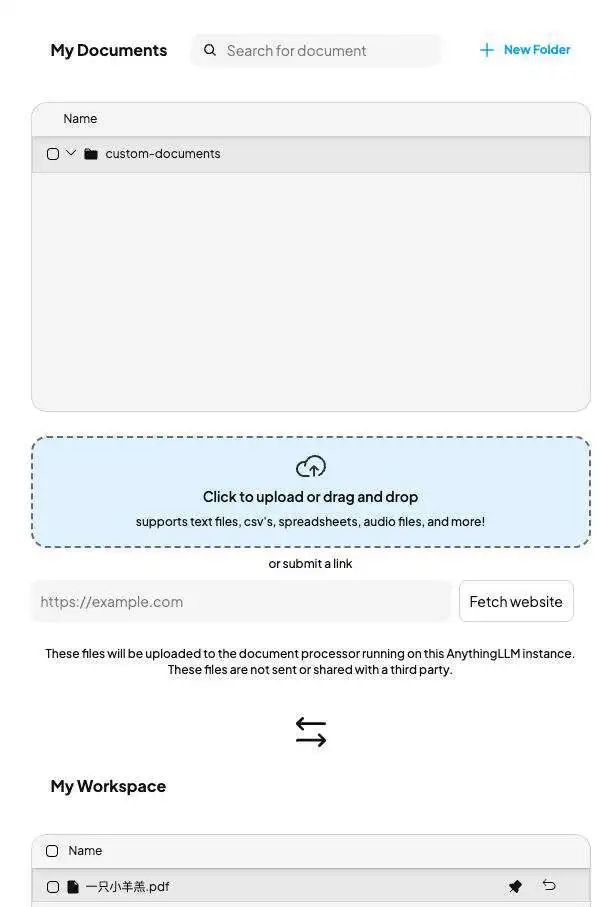

接下来,我使用 Anything LLM 来为 DeepSeek-R1 “投喂”数据。这一次,我仍然选择《一只小羊羔》的 PDF 文档作为实验材料。

然后我们重新开一个对话看效果:

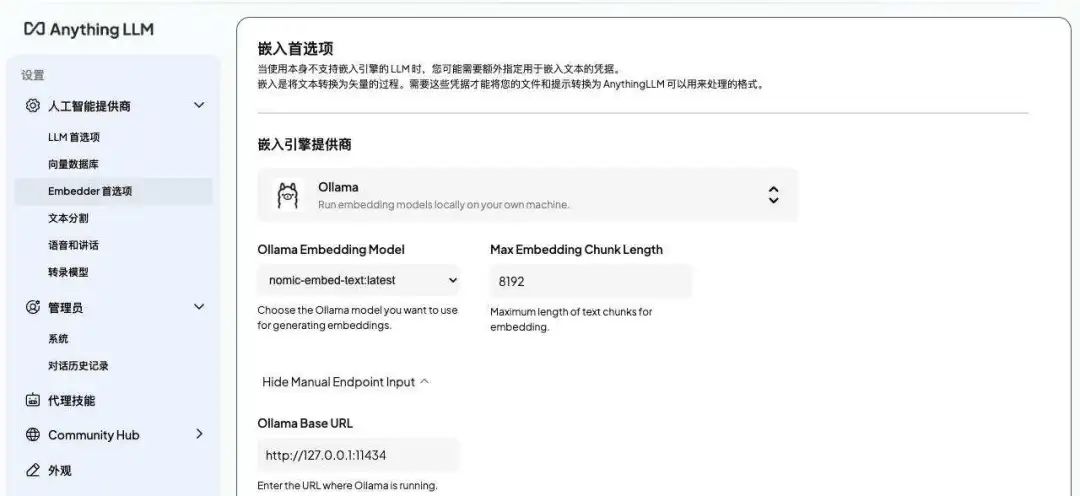

通过 Anything LLM,借助 RAG(检索增强生成)技术,我们发现,本地 AI 大模型终于拥有了记忆能力。这是因为 Anything LLM 运用嵌入引擎和向量数据库,将“投喂”的数据妥善保存,并巧妙转化为 DeepSeek-R1 易于理解和利用的格式,从而赋予了它强大的知识库能力。

通过实验可以发现,借助 Anything LLM 的 RAG 技术,“投喂” 数据后,AI 表现出了显著的提升。这种技术不仅让 AI 拥有了“记忆”,还能够持续利用这些信息为用户提供更精准的服务。

既然我们能实现让 AI 拥有了“记忆”功能,那接下来就是持续收集新内容来提升其价值吧。每天源源不断地将文本文件、PDF、网页抓取内容等知识输入,充实知识库。随着内容的持续更新,知识库不断完善,当被 AI 大模型提取运用,就能与用户需求高度契合,提供更精准、更贴心的服务,最大化发挥 AI 的实用价值 。

本文链接:https://kinber.cn/post/4811.html 转载需授权!

推荐本站淘宝优惠价购买喜欢的宝贝:

支付宝微信扫一扫,打赏作者吧~

支付宝微信扫一扫,打赏作者吧~