使用

ollama在linux服务器部署deepseek R1模型,并使用Chatbox远程连接。

测试环境,测试centos7同样的设置也适用:

centos:8

ollama:0.5.7

deepseek R1::1.5b

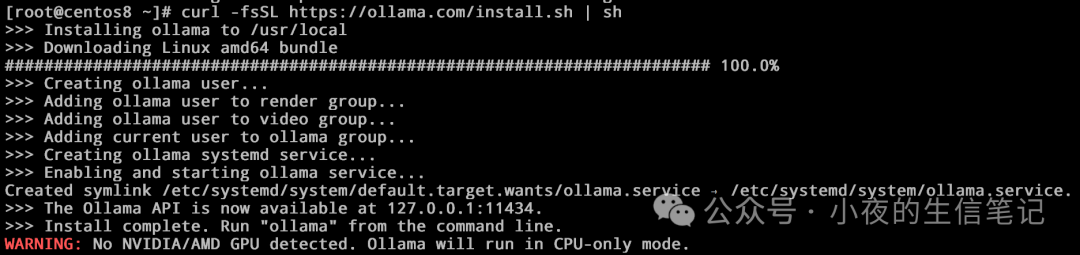

安装ollama:

# 需要root权限

curl -fsSL https://ollama.com/install.sh | sh

测试服务器中没有GPU,会报警告。不会影响小数据测试使用。

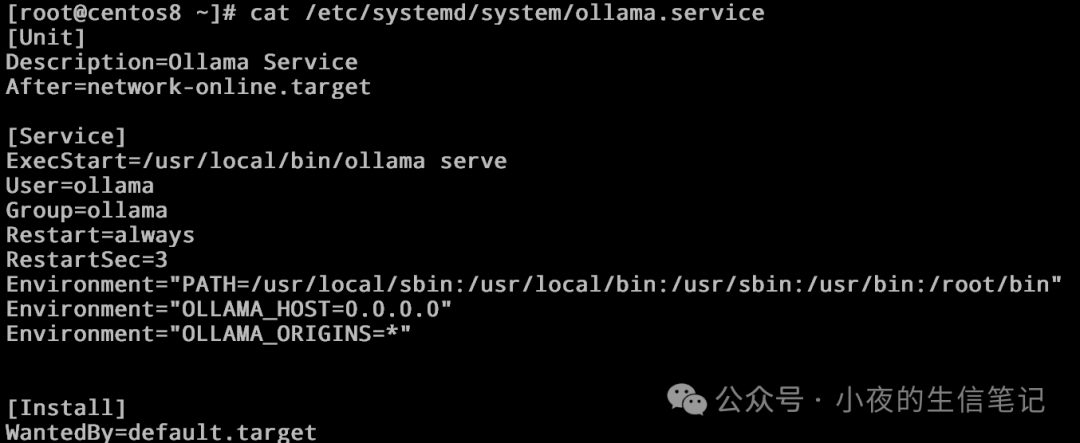

配置ollama可以外部ip访问:

vi /etc/systemd/system/ollama.service

# 在Service中增加下面两行

Environment="OLLAMA_HOST=0.0.0.0"

Environment="OLLAMA_ORIGINS=*"

# 然后重启ollama服务

systemctl daemon-reload

systemctl restart ollama

服务重启后11434端口应该是这样的:

netstat -tulpn | grep 11434

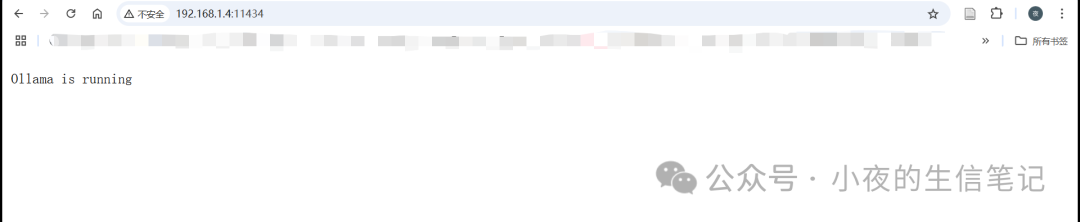

此时外部浏览器访问服务器ip会显示Ollama is running:

然后使用ollama命令运行1.5B模型:

ollama run deepseek-r1:1.5b

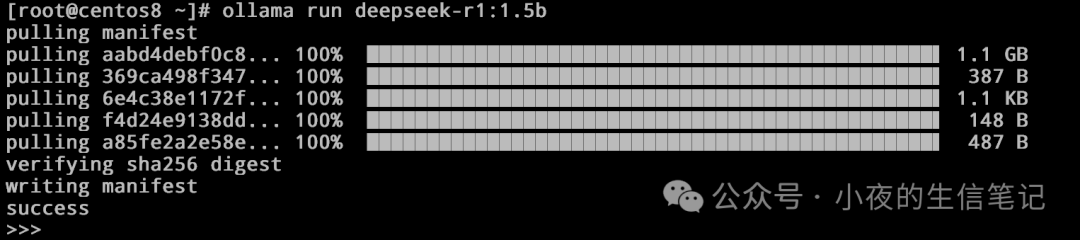

首次运行如图:

第一次运行会pull模型,之后再运行就可以直接进入:

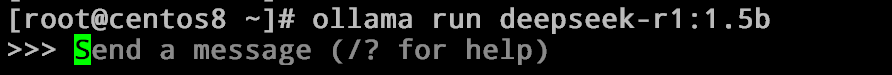

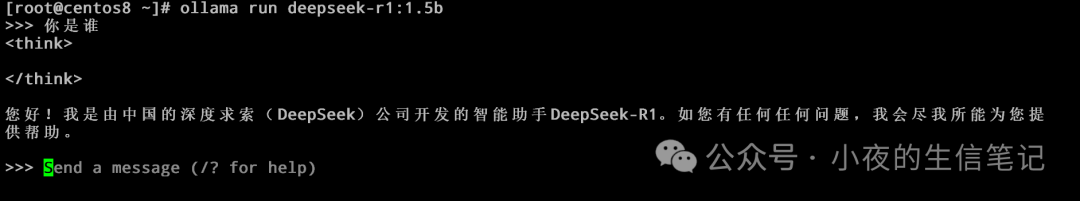

可以再提示框里面输入问题:

使用Chatbox在windows上访问linux服务器上的1.5B模型,首先在windows上安装Chatbox,官网:https://chatboxai.app/zh

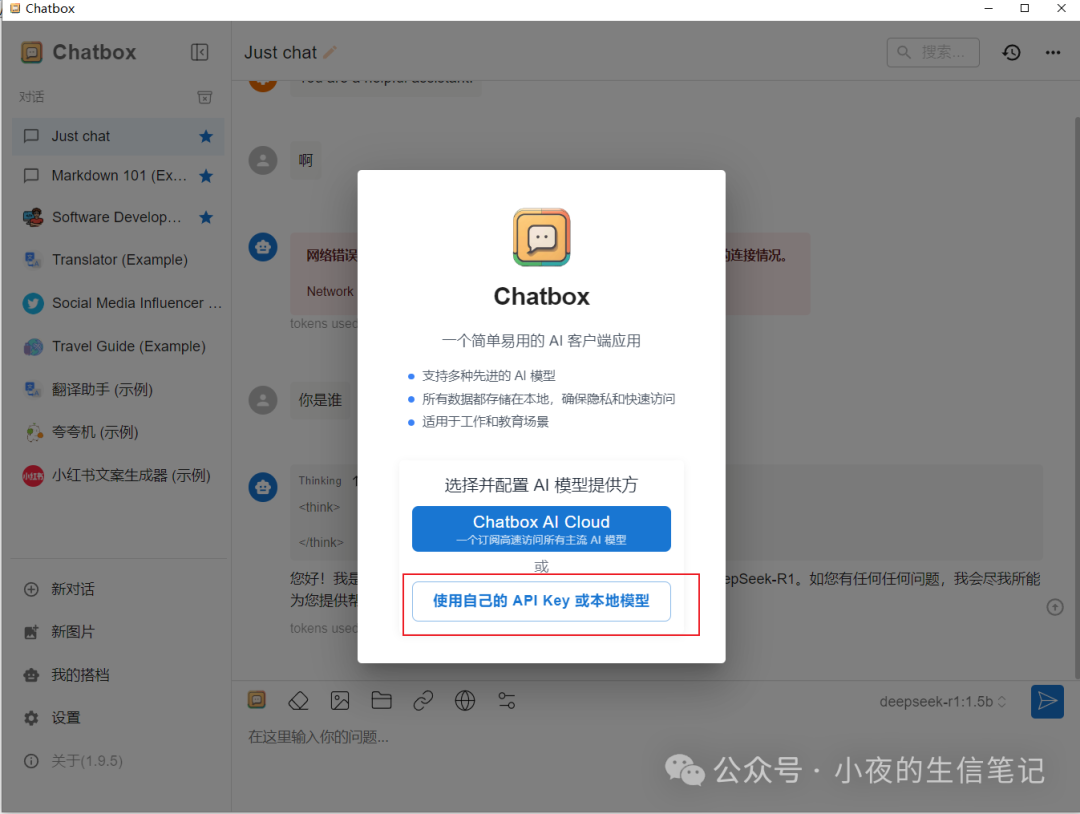

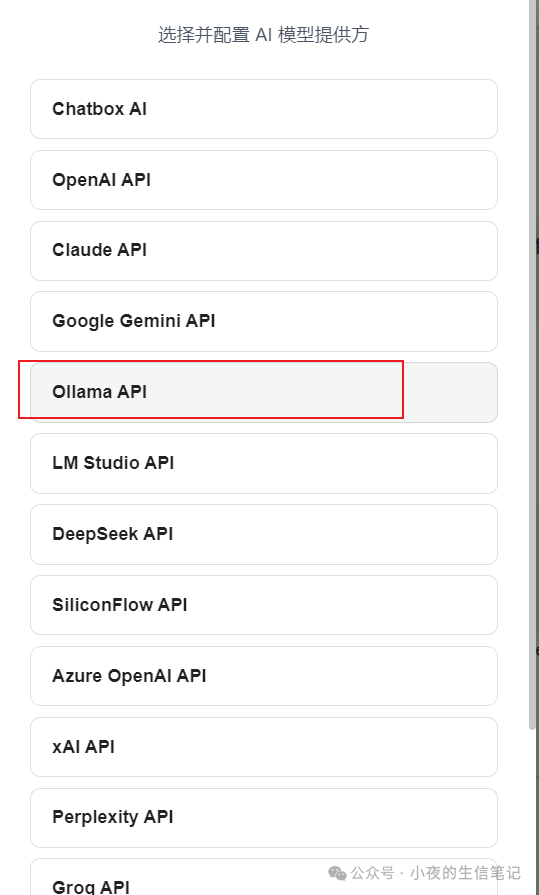

打开Chatbox进行配置:

输入自己的IP地址及配置的模型,然后保存:

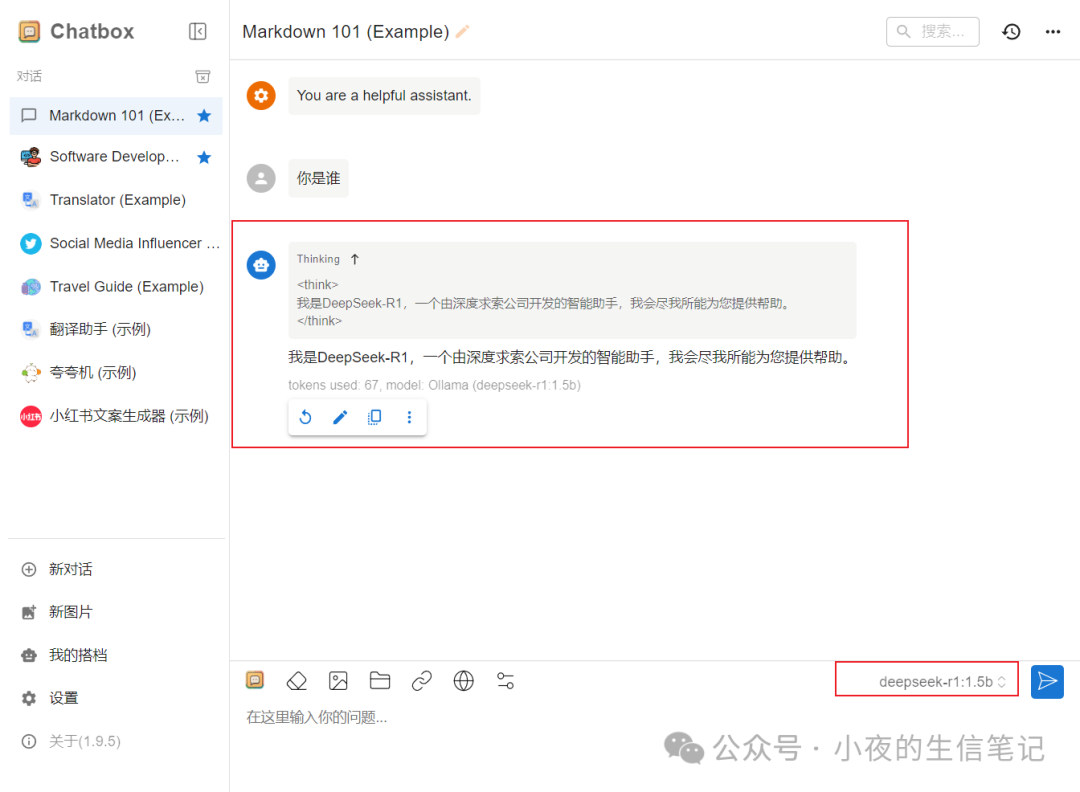

进行对话测试:

注意事项:

0.0.0.0设置表示所有IP均可访问服务器,此项慎用,容易遭到攻击。最好固定IP进行访问。R1有大小不同的几个,根据自己的服务配置,选择合适的模型,跑较大的模型时,最好有GPU。外部访问,

linux服务器一定要打开11434端口。

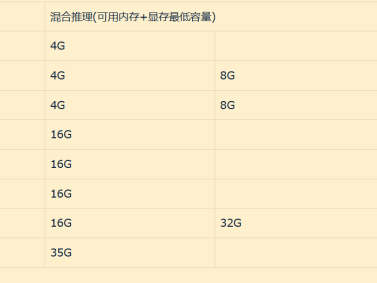

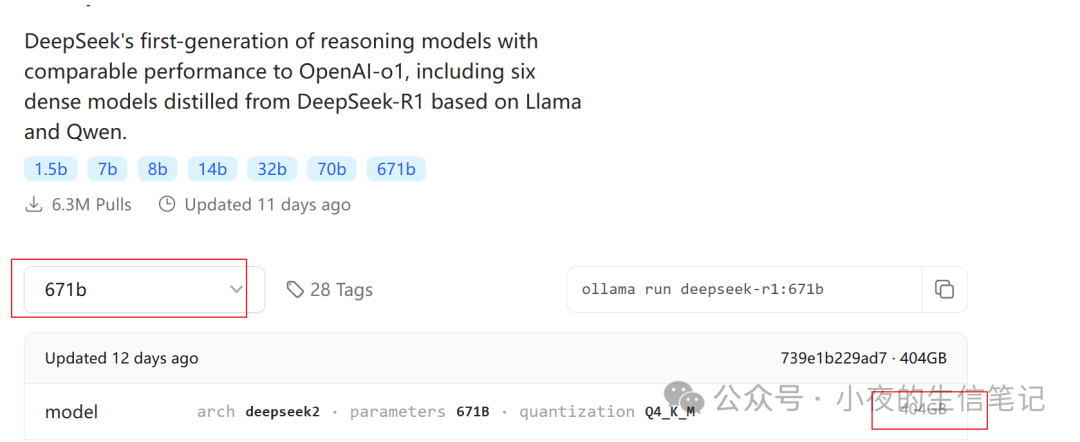

R1最大的模型为671B,需要404G的存储,https://ollama.com/library/deepseek-r1:671b:

linux服务器打开端口命令参考(根据系统环境配置不同,哪条命令成功用哪个):

firewall-cmd --zone=public --add-port=11434/tcp --permanent

iptables -I IN_public_allow -p tcp --dport 11434 -j ACCEPT

iptables -I INPUT -p tcp --dport 11434 -j ACCEPT

参考链接:

https://www.cnblogs.com/xyztank/articles/18692502

https://chatboxai.app/zh/help-center/connect-chatbox-remote-ollama-service-guide

本文链接:https://kinber.cn/post/4809.html 转载需授权!

推荐本站淘宝优惠价购买喜欢的宝贝:

支付宝微信扫一扫,打赏作者吧~

支付宝微信扫一扫,打赏作者吧~